Si queremos fortalecer nuestra presencia profesional en línea, LinkedIn es una de las mejores plataformas para hacerlo. No solo es una red social para conectar con otros profesionales, sino que también nos permite mostrar nuestra experiencia, compartir contenido y generar oportunidades de negocio. Pero, ¿cómo podemos aprovechar todo esto en nuestro sitio de WordPress?

La respuesta está en los plugins de LinkedIn para WordPress. Estas herramientas facilitan la integración de LinkedIn en nuestro sitio web WordPress, permitiendo mostrar perfiles, compartir contenido de forma automática, agregar botones de seguimiento y aceptar solicitudes de empleo.

Si tenemos un blog en WordPress, una tienda en línea o un sitio corporativo, contar con un plugin de LinkedIn puede ayudarnos a atraer más visitantes, generar confianza y facilitar la interacción con nuestra audiencia. Lo mejor es que hay opciones para diferentes necesidades, desde plugins que añaden un simple botón de compartir hasta herramientas más avanzadas que permiten el inicio de sesión con LinkedIn o la publicación automática de nuestros artículos en esta red.

En esta guía, exploraremos los mejores plugins de LinkedIn para WordPress, sus características y cómo pueden ayudarnos a aprovechar al máximo esta integración. Si queremos llevar nuestra presencia en LinkedIn al siguiente nivel, aquí encontraremos las herramientas perfectas para lograrlo.

¡Empecemos!

Tabla de contenidos

- 1 Vídeo sobre la optimización de robots.txt

- 2 ¿Qué es el robots.txt?

- 3 ¿Para qué usar robots.txt?

- 4 Cómo crear el archivo robots.txt en WordPress

- 5 ¿Cómo indicar a Google que he creado el robots.txt?

- 6 Cómo es el archivo robots.txt creado por defecto en WordPress

- 7 Comodines a utilizar en robots.txt

- 8 Cómo optimizar el Robots de WordPress

- 9 ¿Necesitas un archivo robots.txt?

- 10 Cómo editar el robots.txt de WordPress de forma manual

- 11 Cómo editar el robots.txt de WordPress con plugin

- 12 Conclusiones

Vídeo sobre la optimización de robots.txt

En el siguiente vídeo te muestro cómo puedes mejorar el archivo robots.txt WordPress y optimizarlo para buscadores en tu sitio web.

¿Qué es el robots.txt?

El robots.txt WordPress es un pequeño fichero que permite indicar a los bots de los buscadores que partes de un sitio web pueden estos rastrear y cuáles no.

Cuando el robot de Google, Bing, Yandex o cualquier otro buscador accede a una web, lo primero que hace es buscar el archivo robots.txt WordPress, si lo tienes creado, ya que por defecto no lo verás en tu instalación.

Con base en ello tomará una u otras decisiones de análisis en función de las directivas que tengas establecidas en dicho archivo.

Si no lo tienes creado, accederá sin atender a ninguna orden o prohibición indicada, lo cual puede ser en ocasiones perjudicial, sobre todo en webs de mucho contenido.

En resumen: el archivo robots.txt no es obligatorio, pero sí muy recomendable optimizarlo porque ayudará al posicionamiento de tu web.

¿Para qué usar robots.txt?

De la misma manera que debes hacer que Google no indexe URL que no son importantes de tu web, indicando como directiva noindex páginas de política de privacidad, política de cookies, aviso legal, o “URL con contenido que no se busca en Google”; debes usar el fichero robots para cerrar el acceso de forma más drástica a Google a esas URL o partes de la web.

No debes confundir la directiva noindex con robots.txt WordPress, ya que sus funciones son diferentes.

- Noindex: No muestra unas determinadas páginas en las SERP o lo que es lo mismo, permite a Google indexar un contenido.

- Robots.txt: Bloquea el acceso a las URL marcadas para que Google no pueda leer el HTML en WordPress, lo que incluye leer el noindex.

Google recomienda usar noindex para no mostrar URL en las SERP:

Si no deseas que determinadas páginas aparezcan en los resultados de búsqueda, “no utilices el archivo robots.txt para ocultar tu página web”, tal como explica Google.

Aunque las órdenes indicadas en el robots.txt WordPress suelen ser obedecidas por los buscadores, no son efectivas al 100 % pudiendo Google u otros obviar las instrucciones indicadas y rastrear las URL bloqueadas.

Según dice Google, la información que das en tu archivo robots.txt WordPress son instrucciones, no reglas.

Si varios enlaces apuntan a esta página, es posible que Google la indexe y la muestre en sus resultados de búsqueda, sin saber lo que contiene, incluso si la has bloqueado en tu archivo robots.txt

Cómo crear el archivo robots.txt en WordPress

Para ver si una web tiene creado un archivo robots.txt WordPress solo tienes que indicar después del dominio /robots.txt.

Ejemplo: tu-dominio.com/robots.txt

La creación del archivo robots.txt WordPress es muy sencilla y puedes hacerlo de varias formas:

Te explico a continuación estos 2 métodos.

Crear el archivo robots.txt de forma manual

Esta opción es recomendable si no utilizas plugins específicos de SEO que además integren la opción de crear el archivo robots, porque no vale la pena instalar un plugin solo para crear el archivo de robots, en cuyo caso el método manual es mucho más recomendable, rápido y eficiente.

Si tu sitio no tiene un archivo robots.txt WordPress deberías crearlo y luego puedes usar de guía el código incluido en el apartado Cómo optimizar el Robots al máximo y personalizarlo para tu sitio y necesidades.

Crear y añadir contenido al archivo robots.txt

Como puedes ver, se crea un archivo robots prediseñado por defecto que podrás guardar y ya lo tienes creado a falta de indicar el sitemap.

Para ello, tanto si usas Yoast SEO como un blog de notas, debes indicar la siguiente línea:

– Si usas el plugin Google XML Sitemap:

Sitemap: tusitioweb.com/sitemap.xml– O si usas el sitemap del plugin Yoast SEO:

Sitemap: tusitioweb.com/sitemap_index.xmlPara insertar el mapa del sitio dentro del robots.txt WordPress solo tienes que copiar la ruta de tu sitemap, con tu dominio, en el archivo robots.txt WordPress

Recuerda pegarlo al final del fichero creado robots.txt.

Crear el archivo robots.txt con Yoast SEO

Si ya tienes instalado el plugin Yoast SEO porque lo utilizas para gestionar el SEO on-page de tus publicaciones y del sitio en general, entonces puedes aprovechar la funcionalidad que incorpora para crear el archivo robots.txt WordPress sin tener que irte al Administrador de Archivos de tu Hosting a crearlo.

Para acceder a esta opción vete a:

Yoast SEO Herramientas Editor de archivos Crear robots.txt

Te abrirá una ventana dentro de ese mismo apartado, con un texto mínimo viable para tu archivo robots.txt WordPress y en él podrás añadir contenido personalizado, como por ejemplo el indicado en el bloque de este artículo Cómo optimizar el Robots al máximo.

Recordarte que es un texto “guía” del que tú debes extraer aquello que te interese activar y personalizar los bloques de acuerdo a tus necesidades, ya que la solución no es “copiar y pegar tal cual el bloque sin saber qué le estás diciendo al archivo que haga, no vaya a ser que acabes bloqueando el rastreo de tu web a todos los bots de indexado.

Si es cierto que desde el plugin Yoast SEO, la creación del archivo de rastreo a los bots de los motores de búsqueda es mucho más sencilla y si ya usabas el plugin, pues es otra forma adicional de seguir sacándole partido al mismo.

Lo siguiente será decirle a Google y otros buscadores (Bing, Yandex, etc.) que tienes un archivo robots.txt WordPress (o que lo has modificado, si es el caso) para que lo rastreen y se apliquen las restricciones o permiso de rastreo indicados en el archivo.

Lo más importante en este caso es que podrán rastrear de nuevo todo tu sitio para detectar contenidos indexables.

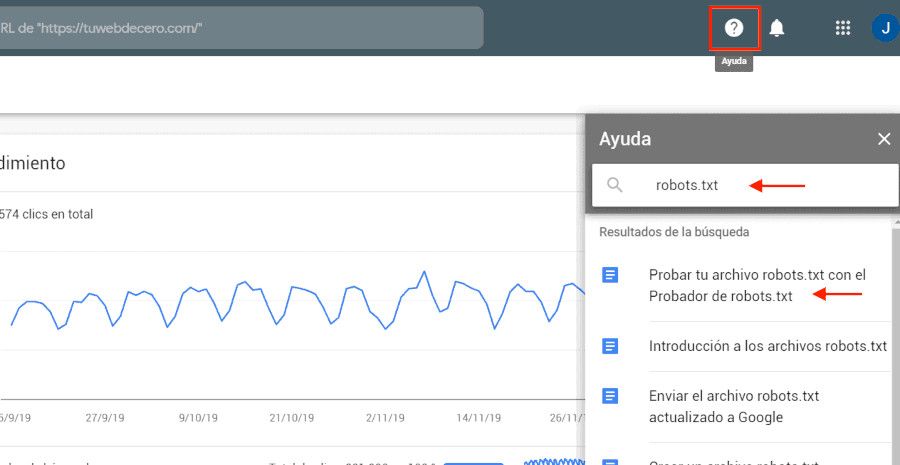

¿Cómo indicar a Google que he creado el robots.txt?

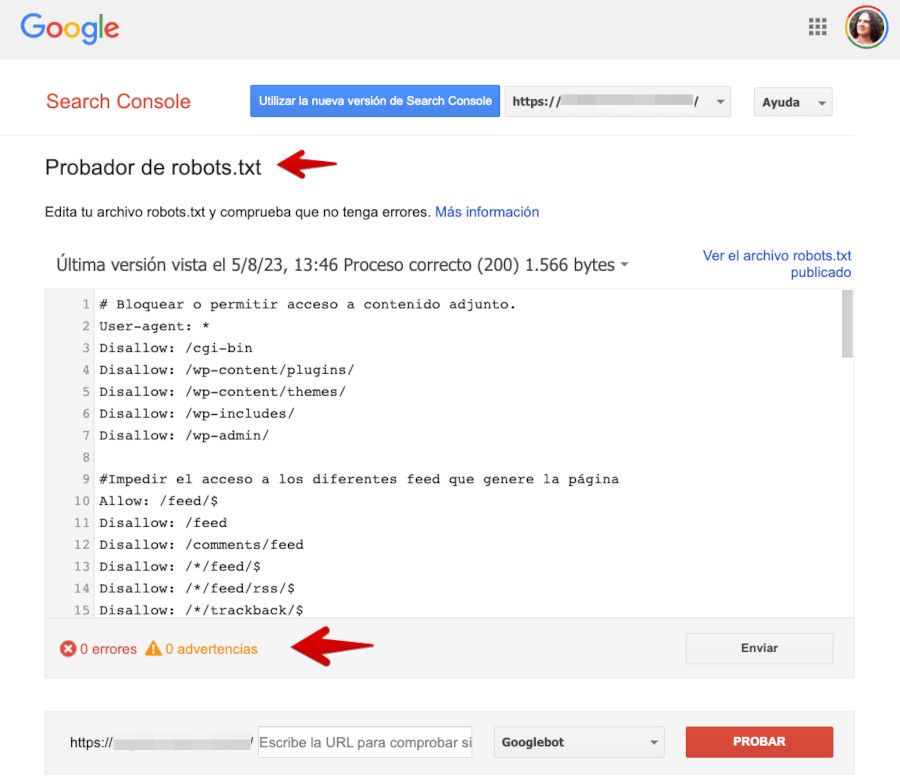

Muy sencillo, accede a tu Google Search Console y en el apartado de Ayuda (?) escribe: robots.txt WordPress.

Aparecerá como primer resultado: Probar tu archivo robots.txt WordPress. Haz clic y se abrirá la herramienta de robots.txt WordPress.

Ten en cuenta que no es lo mismo subir el archivo Robots.txt WordPress que validarlo en Google Search Console, para validarlo tendrás que haberlo creado con anterioridad.

Escoge una propiedad (tu dominio) y copia y pega el contenido del archivo robots.txt WordPress creado en el blog de notas o en Yoast.

Haz clic en enviar y escoge la opción “Solicita a Google la actualización”.

Te dejo un enlace directo al validador de Robots.txt de Search Console

Asegúrate de que no genera error.

Ya solo tienes que acceder al navegador y escribir tusitioweb.com/robots.txt y ver si se muestra.

Google Search Console sigue haciendo mejoras y cambios en su interfaz, es posible que cambie o añada esta opción de probador en otro sitio más adelante

Con esto ya tendrás el archivo robots.txt WordPress creado y estarás facilitando el rastreo en Google aunque es personalizable todo lo que quieras.

Tienes que tener cuidado porque cada web es diferente y un error en un simple * o / puede hacer que Google no rastree partes que sí son importantes.

Vamos a ver el robots creado por defecto y las diferentes opciones para crear un archivo robots a medida.

Cómo es el archivo robots.txt creado por defecto en WordPress

En WordPress, el archivo robots.txt WordPress, por defecto, es un archivo en blanco, lo que significa que no hay ninguna directiva específica establecida en el mismo.

Sin embargo, los motores de búsqueda como Google o Bing siguen ciertas prácticas para indexar y rastrear los sitios de WordPress. Por ejemplo, no indexan de forma automatica las páginas de administración de WordPress, lo que sería el dashboard, la página de inicio de sesión o el panel de administración.

También respetan las etiquetas meta en WordPress como noindex y nofollow establecidas en las páginas o publicaciones individuales.

Si necesitas personalizar el archivo robots.txt WordPress en tu sitio de WordPress, puedes hacerlo añadiendo directivas específicas para controlar qué partes de tu sitio quieres que los motores de búsqueda indexen o no.

Puedes crear o modificar el archivo desde la raíz de tu instalación de WordPress utilizando un editor de texto plano o de código, aunque lo mejor es editarlo usando el Administrador de Archivos de tu Panel de Hosting.

Este es el código que por defecto puede incluir el archivo robots.txt WordPress en WordPress, en caso de que ya esté creado, aunque lo normal es que no exista el archivo una vez instalada la web o esté vacío.

*

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php*Aquí habría que añadir la línea de tu sitemap.

En ellas vemos disallow (no permitir) y allow (permitir).

En él existen 3 líneas:

- User-agent: *: Permite a todos los buscadores rastrear tu web.

- Disallow: /wp-admin: Evita que los buscadores pierdan tiempo en rastrear el administrador de WordPress.

- Allow: /wp-admin/admin-ajax.php/: Dentro de la prohibición anterior, los buscadores sí deben rastrear admin-ajax-php.

Si tu web estuviera bloqueada para los motores de búsqueda (opción en los ajustes de WordPress mientras se diseña una web) tú robots tendría un Disallow: /.

Tienes que tener cuidado porque si mostrará esto estás diciendo a Google que no rastree nada de tu web.

La parte más importante en un robots.txt WordPress se encuentra en los comodines, es importante conocer todos los códigos a emplear como el signo del *, el $, etc. Te lo muestro.

Comodines a utilizar en robots.txt

Al configurar el archivo robots.txt WordPress en WordPress, algunos caracteres especiales pueden marcar la diferencia entre una configuración efectiva y el bloqueo accidental de contenido importante. Estos comodines permiten definir reglas más dinámicas, optimizando cómo los motores de búsqueda acceden a nuestro sitio web. Vamos a repasarlos de manera sencilla para que podamos usarlos con confianza.

Almohadilla (#) – Para añadir comentarios

Uno de los elementos más simples, pero útiles dentro del robots.txt WordPress WordPress es la almohadilla (#). Aunque no afecta cómo los motores de búsqueda rastrean nuestro sitio, su función es crucial para mantener el archivo organizado y comprensible. Al usar varias reglas en robots.txt WordPress, los comentarios ayudan a recordar el motivo de las restricciones y facilitan su comprensión para otros administradores.

Por ejemplo, si hemos bloqueado una carpeta en particular, podemos añadir una nota explicativa:

# Bloqueo del directorio de administración

Disallow: /wp-admin/

Lo que obtendremos con esto es que el Googlebot va a ignorar la línea con # y solo aplicará la directiva Disallow.

Asterisco (*) – Representa cualquier secuencia de caracteres

El asterisco (*) es uno de los comodines más versátiles en robots.txt WordPress porque nos permite crear reglas generales sin necesidad de especificar cada URL de manera individual.

Funciona como un comodín universal que representa cualquier conjunto de caracteres dentro de una URL. Esto es en especial útil cuando queremos bloquear o permitir páginas con patrones similares sin escribir cada una de forma manual.

Por ejemplo, si queremos evitar que Google rastree cualquier archivo en formato PDF en WordPress o los que sigan a una referencia sin importar en qué parte del sitio se encuentre, podemos usar la siguiente regla:

Disallow: /*.pdf

Disallow: /*?ref=

Símbolo de dólar ($) – Indica el final de una URL

A veces, no solo queremos bloquear ciertas páginas o archivos en nuestro robots.txt WordPress, sino asegurarnos de que la regla solo se aplique a URL que terminen de una manera específica. Aquí es donde entra en juego el símbolo de dólar ($), que indica el final exacto de una URL.

Supongamos que queremos bloquear solo las imágenes en formato JPG sin afectar otras páginas o recursos que contengan jpg en su estructura. En este caso, usaríamos la siguiente regla:

Disallow: /*.jpg$

Con esta configuración, todas las URLs que terminen en .jpg serán bloqueadas, pero si una imagen forma parte de una URL más larga con parámetros adicionales, como imagen.jpg?size=large, esta regla no la afectará.

Es un detalle importante cuando queremos ser precisos en la configuración de nuestro archivo robots.txt WordPress y asegurarnos de que solo las páginas o archivos específicos sean restringidos para los motores de búsqueda.

User-agent – Aplicando reglas a bots específicos

El comando User-agent es fundamental dentro de robots.txt, ya que nos permite aplicar reglas a rastreadores específicos o a todos los motores de búsqueda en general. Esto es útil cuando queremos diferenciar cómo distintos bots interactúan con nuestro sitio.

Si queremos que todas las reglas dentro del archivo se apliquen a cualquier motor de búsqueda, utilizamos User-agent: *:

User-agent: *

Disallow: /privado/

Con esto, todos los bots respetarán la restricción de acceso a /privado/. Pero si, por ejemplo, queremos que solo Googlebot evite una sección específica mientras otros rastreadores sí pueden acceder, podemos personalizar la regla así:

User-agent: Googlebot

Disallow: /test/

Esto bloqueará a Googlebot en /test/, pero otros motores de búsqueda, como Bingbot, podrán seguir accediendo. Esta flexibilidad nos permite controlar qué partes de nuestro sitio queremos ocultar a ciertos motores de búsqueda sin afectar a todos por igual.

Allow y Disallow – Definiendo accesos en robots.txt

Dentro de nuestro robots.txt WordPress, dos de las directivas más importantes son Disallow y Allow. Mientras que Disallow impide que los bots accedan a ciertas rutas, Allow hace excepciones dentro de directorios bloqueados. Esta combinación es clave cuando queremos restringir una carpeta completa pero permitir el acceso a ciertos archivos dentro de ella.

Un caso común en WordPress es bloquear el acceso a wp-admin, pero permitir que ciertos archivos sigan siendo accesibles para garantizar el correcto funcionamiento del sitio:

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

¿Qué ocurre con el Linkjuice en un Disallow?

El linkjuice (fuerza de una página) no se traspasaría a otra URL si estamos bloqueando por robots la primera.

Te lo explico:

Ejemplo: Imagina que marcas:

Disallow: /servicio1/Servicio1 recibe enlaces de la home y a su vez servicio1 tiene enlaces hacia servicio2.

Servicio1 seguirá recibiendo su fuerza pero no la traspasará a servicio2 ya que hemos bloqueado por robots esa url.

Noindex y nofollow

Antes, se podía utilizar Noindex dentro del robots.txt WordPress para indicar a los motores de búsqueda que no indexaran ciertas páginas. Sin embargo, desde 2019, Google dejó de soportar esta directiva en robots.txt. Si aún tenemos reglas de este tipo en nuestro archivo, es recomendable eliminarlas y buscar alternativas más efectivas para evitar la indexación de contenido no deseado.

La mejor opción hoy en día es utilizar meta robots en cada página específica o configurar reglas a nivel de servidor mediante el archivo .htaccess. De esta manera, garantizamos que las páginas que no queremos indexar no sean mostradas en los resultados de búsqueda.

Cómo optimizar el Robots de WordPress

No hay una regla fija y tienes que tener cuidado a la hora de replicar los robots de otras webs, ya que puede ser contraproducente.

Un ejemplo de un robots estándar con algunas reglas puede ser el siguiente:

# Bloquear o permitir acceso a contenido adjunto. (Si la instalación está en /public_html).

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Disallow: /wp-includes/

Disallow: /wp-admin/

#Impedir el acceso a los diferentes feed que genere la página

Allow: /feed/$

Disallow: /feed

Disallow: /comments/feed

Disallow: /*/feed/$

Disallow: /*/feed/rss/$

Disallow: /*/trackback/$

Disallow: /*/*/feed/$

Disallow: /*/*/feed/rss/$

Disallow: /*/*/trackback/$

Disallow: /*/*/*/feed/$

Disallow: /*/*/*/feed/rss/$

# Impedir URLs terminadas en /trackback/ que sirven como Trackback URL.

Disallow: /*/*/*/trackback/$

# Evita bloqueos de CSS y JS.

Allow: /*.js$

Allow: /*.css$

#Bloquear todos los pdfs

Disallow: /*.pdf$

#Bloquear parámetros

Disallow: / *?

# Lista de bots que deberías permitir.

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: Adsbot-Google

Allow: /

User-agent: Googlebot-Mobile

Allow: /

# Lista de bots bloqueados

User-agent: MSIECrawler

Disallow: /

User-agent: WebCopier

Disallow: /

User-agent: HTTrack

Disallow: /

User-agent: Microsoft.URL.Control

Disallow: /

User-agent: libwww

Disallow: /

User-agent: Baiduspider

Disallow: /

User-agent: GurujiBot

Disallow: /

User-agent: hl_ftien_spider

Disallow: /

User-agent: sogou spider

Disallow: /

User-agent: Yeti

Disallow: /

User-agent: YodaoBot

Disallow: /

#Desautorizar a páginas innecesarias

Disallow: /gracias-por-suscribirte

# Añadimos una indicación de la localización del sitemap

Sitemap: https://sitioweb/sitemap_index.xmlEl objetivo no es que copies este archivo “tal cual” te lo muestro y lo pegues en tu archivo robots.txt WordPress sin más porque no siempre este se va a adaptar a tus contenidos y a la estructura del sitio web.

Es un texto guía para que lo analices, tal como he desmenuzado en el apartado Cómo es el robots.txt WordPress creado por defecto en WordPress de este artículo, de manera que entiendas su verdadero funcionamiento y así decidir qué añades y que no a tu archivo, o qué personalizas para tu caso.

Ya que por ejemplo es posible que tú sí quieras permitir el rastreo de contenidos de tu sitio por parte de crawlers como Baiduspider porque tienes público objetivo en ese país, idioma o servicio de indexado del buscador en cuestión y quieres permitir las arañas solo Baidu -el mayor motor de búsqueda de China- y bloquear las arañas de motores de búsqueda más pequeños.

Puedes querer hacer disallow a los comentarios, etiquetas, etc. Cada web es diferente, pero piensa si quieres que los buscadores pierdan tiempo en rastrear eso.

¿Necesitas un archivo robots.txt?

Esta es la pregunta que te puedes hacer en un momento dado.

Como te he mencionado, tener un robots.txt WordPress no es esencial para sitios pequeños, aunque la recomendación es que puedes usarlo y así mejorar el posicionamiento cuando lo utilices.

Un buen robots.txt WordPress creado puede ayudarte en:

- Tareas de mantenimiento al poder incluir un Disallow: /

- Prevención de sobrecarga del servidor, ya que pueden existir menos peticiones a páginas innecesarias.

- Evitar que Google desperdicie el presupuesto de rastreo, aumentando la probabilidad de mejor acceso y por más tiempo a páginas relevantes.

- Puedes evitar contenido duplicado. Puedes evitar que se rastreen páginas como el checkout o el carrito en una tienda online (Disallow: /checkout/ y Disallow: /cart/)

- …

El robots.txt WordPress solo es independiente de los subdominios.

Es decir, si tienes un subdominio creado tienes que crear un robots específico para el subdominio creado.

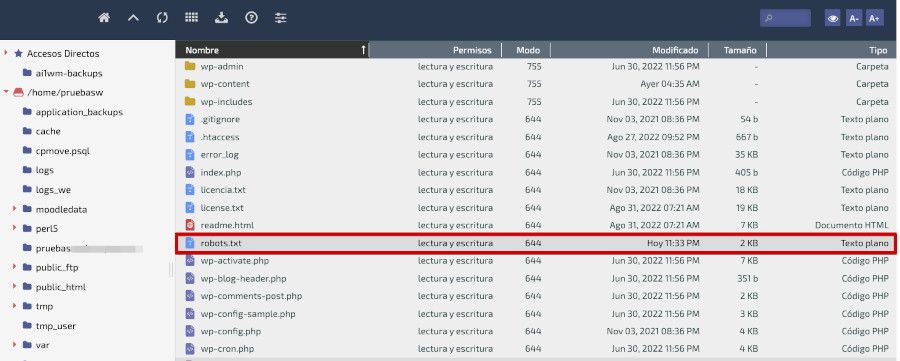

Cómo editar el robots.txt de WordPress de forma manual

Para poder crear el archivo robots.txt WordPress necesitas de una u otra forma acceder a la carpeta donde se encuentra la instalación de tu web, que puede ser public_html si solo tienes una web y esta no cuelga de ninguna carpeta específica, o si tienes varias webs, separadas por dominios, subdominios, etc., estará entonces dentro de una carpeta public_html/tu-dominio.es o similar, dependiendo del nombre que pusieras cuando lo instalaste.

En dicha carpeta debería encontrarse el archivo robots.txt WordPress para que puedas editarlo y aplicar cambios, optimizarlo o realizar las acciones necesarias.

La mejor manera de editar siempre el archivo robots es utilizando el Administrador de Archivos de tu panel de Hosting, que es usual que incluya por defecto algún tipo de editor de texto plano, de código o similar, con el que una vez seleccionas el archivo, puedes editarlo para ver su contenido.

Si no tienes claro que vas a hacer en dicho archivo al editarlo, es importante que antes de aplicar algún cambio en el mismo, te descargues una copia de seguridad a tu ordenador, del citado fichero, por si acaso.

Una vez aplicas los cambios que sean podrás Guardar los mismos con la opción que tu editor de archivos del filemanager disponga.

Los espacios cuenta en este archivo, así que no te prodigues en separar mucho los contenidos unos de otros porque eso suma a la hora de rastrear e interpretar dicho fichero.

Cómo editar el robots.txt de WordPress con plugin

Antes has visto cómo crear o editar el archivo robots.txt WordPress con un plugin, y la verdad es que es supersencillo y en ocasiones, sobre todo si no tienes acceso a FTP del sitio web o al Panel de Hosting porque eres “colaborador/a o autor/a” en el sitio, sin permisos suficientes.

En estos casos recurrir a plugins puede ser viable porque si tienes permisos para instalar plugins o administrar los que estén instalados (cuestión de roles que debes consultar con el administrador del sitio si no eres admin) si necesitas modificar el archivo de robots, hacerlo mediante un plugin específico es una buena ayuda a tu trabajo de mantenimiento o de SEO del sitio web en cuestión.

En WordPress para todo hay un plugin 😜 y este caso no podía ser menos, como puedes ver en este breve listado:

- Virtual Robots.txt: Ver plugin – Detecta si existe el fichero XML del sitemap. Aplica algunos bloqueos por defecto.

- XML Sitemap & Google News: Ver plugin – Genera archivos robots.txt dinámicos.

- WordPress Robots.txt optimization: Ver plugin – Crea y optimiza archivos robots.txt

- Block Archive.org via WordPress robots.txt: Ver plugin – Si no quieres que Archive.org te indexe ¡este es tu plugin!

- Robots.txt Quick Editor: Ver plugin – Para editar archivos robots.txt

- All in One SEO – Best WordPress SEO Plugin: Ver plugin – Un peso pesado de los plugins para estas tareas 👍

- Rank Math SEO: Ver plugin – Un buen plugin de SEO que además lidia con robots.txt

- Block Feed and Comments via robots.txt: Ver plugin – Para bloquear el indexado de los comentarios de tu sitio y los Feeds.

He citado plugins que es posible no conocieras y algunos “grandes plugins” que además te permiten gestionar el archivo robots en tu sitio web, al margen de realizar otras acciones específicas.

Ahora tú decides si lo creas a mano el archivo o si haces uso de alguno de los plugins para poner a raya a los bots, que no olvides que afectan al rendimiento (peticiones) de tu sitio.

Conclusiones

El archivo robots.txt WordPress puede ayudar mucho al rastreo de tu web, pero tienes que asegurarte del buen funcionamiento del mismo.

Una simple coma o mayúscula errónea puede hacer daños importantes en tu web con respecto al SEO.

Bloquear a bot o arañas de rastreo por error puede hacerte perder posicionamiento de forma facil en poco tiempo (días) y si has dedicado mucho tiempo, dinero y esfuerzo a posicionar tu sitio, esto puede acabar en desastre.

Si es o no necesario en todos los sitios depende. Tienes que saber que, en webs pequeñas con arquitecturas sencillas, lo cierto es que los buscadores la rastreen sin problemas.

Incluso existen webs importantes de SEO que comentan no usar robots.txt WordPress, ya que Google es lo suficiente inteligente para entender una web.

Sin embargo, a menudo digo que en el SEO todo ayuda por pequeño que sea.

Si puedes hacer que Google priorice y entienda mejor tu sitio haciéndole ahorrar tiempo, mi recomendación es que uses un robots coherente sin volverte loco.

En este artículo te hablo sobre el archivo robots.txt WordPress, que es utilizado por los motores de búsqueda para saber qué páginas o secciones del sitio web deben ser indexadas y cuáles no. En WordPress, existe un archivo robots.txt WordPress creado por defecto que puede ser editado de forma manual o con la ayuda de plugins.

Además, te explico los diferentes comodines que puedes utilizar en el archivo robots.txt WordPress como la almohadilla (#), user-agent, asterisco (*), símbolo del dólar ($), noindex y nofollow, disallow y allow. También menciono algunas recomendaciones para optimizar al máximo este archivo.

Por último, te planteo si es necesario tener un archivo robots.txt WordPress dependiendo de las necesidades específicas del sitio web y cómo editar este documento tanto de forma manual como a través de plugins especializados.

¡Hasta aquí la Guía sobre Robots, te recomiendo que trabajes en tu robots.txt WordPress y que aumente el rastreo!

¿Te ha resultado útil este artículo?

Miembro del equipo de soporte técnico de Webempresa.

Coordinador de contenidos en el Blog y en Youtube.

Soporte técnico en CiberProtector. Teacher en Webempresa University