Hola de nuevo!

Ya he encontrado que era lo que me tenía bloqueada la edición del archivo robots.txt, era el codigo define( 'DISALLOW_FILE_EDIT', true ); que tenía puesto en code snippets...

puede ser que este codigo haya tambien estado bloqueando la configuración que necesita el plugin webp express para poder hacer conversion bulk? pq a mi se me quedaba paralizada la conversion...

Ahora voy a aplicar toda la optimizacion que pepe me ha comentado del archivo robots.txt y entonces me dedicaré a ver que plugins eliminar, porque puede que tenga varios que hagan lo mismo o similar, algunos nada aconsejados seguramente y otros necesarios, supongo que es la duda que tiene todo el mundo a la, hora de deshacerse de plugins

Contenido solo visible a usuarios registrados

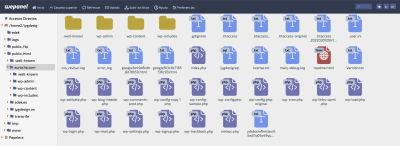

no me parece que esté ese documento creado en la ruta public_html/aurocha no me parece verlo, lo que si veo y no entiendo, es que hay varios archivos .htaccess...

entonces, si no está creado, tengo que crearlo como la guía que me has enviado y eliminar todo lo que puse en rank math?

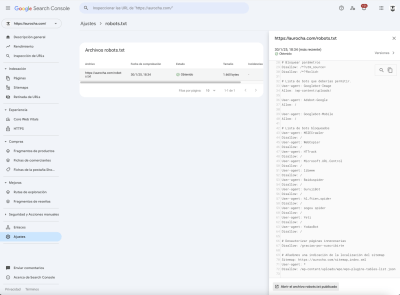

como es que entonces en google search console robots.txt si que aparece el contenido?

Poco a poco conseguiré ir menjorando la web y no os tendré que preguntar tantas cosas... 🙏🏻😅

Gracias!!

Hola, Eduard

Sin intención de desviar el tema de este hilo (robots.txt) el archivo único, válido y que no debe eliminarse nunca es .htaccess, el resto, similares, son backups o copias que algún plugin hizo en algún momento, cuando añadió alguna instrucción o directiva en el mismo.

Puedes, si quieres, eliminar todos esos htaccess excepto el indicado.

Sobre robots.txt:

Como te dije, lo adecuado, sobre todo para sitios web grandes, es NO delegar este archivo a plugins y crearlo tú MANUALMENTE en la carpeta principal de la web, y añadir las sentencias o instrucciones de rastreo o no-rastreo necesarias para tu web.

En el artículo que te he pasado, pongo un ejemplo de archivo "ideal" de robots.txt, que una vez creado deberías validar desde tu Google Search Console.

Hazlo y nos cuentas los resultados. 🙂

Puedes, si quieres, eliminar todos esos htaccess excepto el indicado

Perfecto, gracias!

crearlo tú MANUALMENTE

Ya lo he creado, lo he editado pegando el que se creó que aparece en search console -> robots.txt y lo he guardado ya.

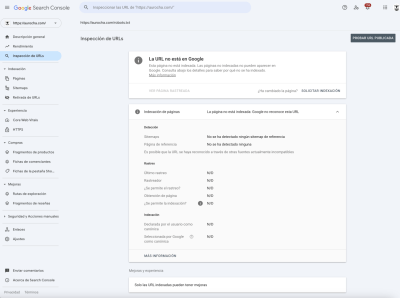

Entonces he hecho un test desde google pagespeed y ahora ya tanto desde movil como desde ordenador detecta bien el archivo robots, pero desde search console me indica que la pagina https://aurocha.com/robots.txt no existe o no esta indexada. tengo desactivados ya los plugins de cerber, optimize, complianz y no se si alguno más...

Gracias!

Hola, Eduard

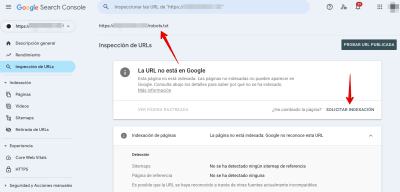

Es normal que Search Console te diga que "no existe" porque NO lo tiene indexado.

Tienes que pedir a GSC que te indexe dicha página desde "Inspección de URLs".

El indexado no es inmediato y puede tardar horas o días en producirse así que toca tener paciencia. El archivo robots.txt es importante, pero no es crítico para una web, por lo que su indexado no afecta al funcionamiento de tu web y a otras tareas de SEO que son más importantes y que si afectan al posicionamiento y tráfico orgánico en tu sitio.

Quedo pendiente de tus indicaciones para seguir ayudándote. 😊

Tienes que pedir a GSC que te indexe dicha página desde "Inspección de URLs".

Voy a ello, muchísimas gracias!!

Aunque no sea del tema, puedes indicarme

otras tareas de SEO que son más importantes y que si afectan al posicionamiento y tráfico orgánico en tu sitio

Para poder ponerme a ello y mejorar todo lo posible?

Gracias!!

Hola, Eduard

Si quieres, para no enturbiar este hilo sobre "robots.txt" te sugiero abrir una nueva consulta tipo "optimizaciones SEO on-page básicas de la web" o como tú quieras titularlo, y lo abordamos, dentro de las limitaciones de Soporte SEO on-page que damos en el Foro. 😊

Gracias por tu colaboración 🤗

google search control ya ha indexado la pagina de robotx.txt y ya he notado diferencia en los test de pagespeed, aunque tengo que mejorar cosas que tocaré en el nuevo hilo abierto de optimizacion de la web...

Gracias!

Hola, Eduard

De nada, gracias a ti. 😊

Cualquier consulta que tengas al respecto, no dudes en comunicarlo.

Cerramos el tema, pero si por cualquier causa necesitas reabrirlo, dínoslo vía ticket citando este hilo y lo reabrimos. 😉

Un saludo