Hola buenas. Tengo un robots.txt que he editado en base a uno de vuestros posts sobre este tema.

Después de revisar una auditoría SEO de SERanking compruebo que todas las páginas me aparecen como bloqueadas por robots, excepto el dominio principal.

Aunque las páginas sí aparecen como indexadas correctamente en Google Search Console.

Sabéis cual puede ser el problema?

Gracias.

Contenido solo visible a usuarios registrados

Hola Joan,

Verificando tu robots.txt no veo que tengas algún bloqueo general a las páginas de tu sitio web, lo mismo sucede si ingreso a alguna página interna veo correctamente la etiqueta de index, follow. En este caso puedes compartirnos algunas capturas sobre los resultados del análisis que realizas de esta forma podemos revisar con mayor detalle lo que nos comentas.

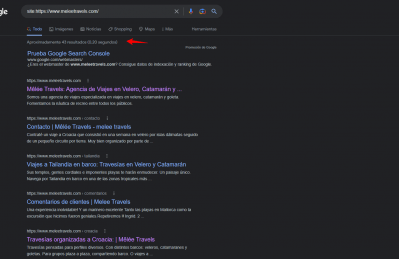

De manera general ten en cuenta que Google está rastreando tu sitio web, ya que muestra los resultados de búsqueda con diferentes páginas como resultados

Un saludo