Buenas,

Pese a tener desmarcado el check de Ocultar la página a buscadores, y tener en la raíz mi propio Robots.txt, la extensión Robots Exclusion Checker me detecta un Disallow para todos los bots, incluyendo Google. 🙃

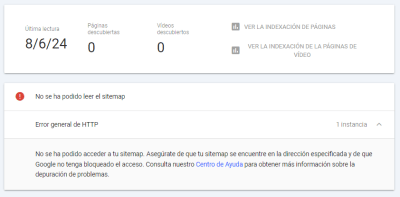

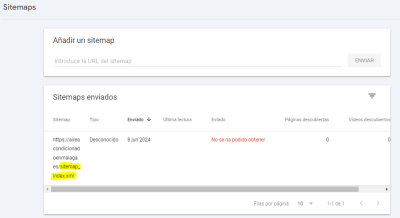

La pista de esto me la ha dado el hecho de que Search Console no pueda acceder al sitemap.

He probado bajando la versión de PHP, desactivando todos los plugins, cambiando de tema, y comprobando si tenía baneado los accesos a la web desde USA, pero aún hay algo que debo estar pasando por alto. Es como si hubiera otro robots.txt.

Contenido solo visible a usuarios registrados

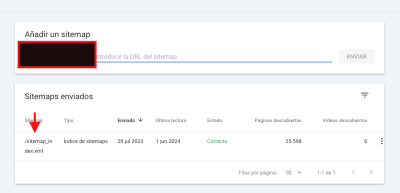

Buen pues tal y como ocurre cuando llevas el coche al taller y ahí decide arrancar, ahora parece que ya Google sí está leyendo el sitemap y acepta la indexación.

Por ahora podemos cerrar este asuntillo. Gracias!

Que tal Vicente,

Tal como tu acertada comparación a Google por lo general es necesario darle un tiempo para que comience a ejecutar sus acciones

Daremos el tema por resuelto pero cualquier otra duda que tengas estaremos atentos

Saludos!