Buenas, desde hace semanas tengo problemas a la hora de que Facebook recoja la vista previa de los artículos en la web. Solo ocurre con Facebook, no con otras redes.

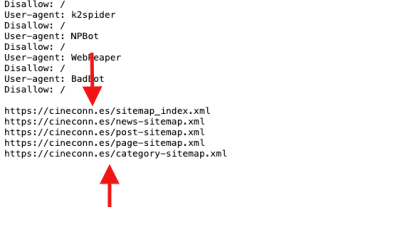

Al ir al depurador de Facebook me saltaba el mensaje que veis en adjunto. He añadido el allow en robots.txt, pero sigue sin solucionarse. He probado también a contactar con nuestro plugin SEO (RankMath) y aseguran que si eso no lo solucionara debía ir acudir al hosting. Y aquí estoy.

En el dominio adjunto podéis encontrar un ejemplo en el que detectar qué está pasando, porque la og:image está y en otras redes no existe este problema, por lo que no tiene que ver ni con el formato de las imágenes ni nada de eso porque no se ha cambiado últimamente.

Muchas gracias,

Contenido solo visible a usuarios registrados

Hola Arturo,

Como el mensaje lo indica tienes bloqueado la opción de facebookexternalhit

Debes editar tú archivos robots.txt y modificar la regla para que los robots de facebook puedan rastrear las imágenes en tu sitio web, por ejemplo debes añadir la regla como:

User-agent: Twitterbot

Allow: /images

User-agent: facebookexternalhit

Allow: /images

Puedes revisar algunas recomendaciones para optimizar tu archivo robots.txt en el siguiente artículo que tenemos disponible → https://www.webempresa.com/blog/robots-txt-en-wordpress-que-problema-tienes-googlebot.html

Verifica añadir esto y comprueba si con ello se soluciona

Un Saludo

Hola, he introducido esas líneas en Robots.txt y sigue sin solucionarse el problema. ¿Qué puedo hacer?

Que tal Arturo,

Revisando tu archivo de robots.txt veo que se ha colocado de manera correcta, si es posible puedes cambiar su orden subiéndolo de posición como es sugerido en un tema similar

https://gist.github.com/peterdalle/302303fb67c2bb73a9a09df78c59ba1d

Tambien aunque pareaca no tener relacion si el archivo de robots.txt ha sido cargado anteriormente a search console, este es necesario que sea actualizado

Valida y nos comentas

Saludos!

Hola Artur.

Lo que te está indicando es que no puede interpretar esas líneas ya que solo son URLs pero no sabe lo que tiene que hacer con esos datos.

Por lo que veo son los Sitemap y falta añadir la etiqueta " Sitemap: "

Contenido solo visible a usuarios registrados

Sobre el error a la hora de utilizar el depurador de Facebook:

.- Añade lo siguiente en el archivo robots.txt:

User-agent: facebookexternalhit Allow: /

Revisa si se soluciona y nos comentas.

Un Saludo

Gracias. Hecho. Supongo que hay que esperar a que se actualice el Search Console. Una duda: ¿Tengo que poner el Sitemap: https://cineconn.es/sitemap_index.xml en cada una de las líneas? (ej. Sitemap: https://cineconn.es/news-sitemap.xml, etc...) o solo con esa primera línea vale?

Que tal Arturo,

Supongo que hay que esperar a que se actualice el Search Console.

Es correcto es necesario esperar a la nueva indexación

Una duda: ¿Tengo que poner el Sitemap: https://cineconn.es/sitemap_index.xml en cada una de las líneas? (ej. Sitemap: https://cineconn.es/news-sitemap.xml, etc...) o solo con esa primera línea vale?

Con colocar el index de todos los sitemap debería de bastar

Saludos!