Buenas tardes a tod@s. Llevo unos meses con un problema y por mucho que he googleado no he encontrado la solución o al menos no se aplicarla. Actualmente tengo en el apartado de search console Cobertura/No se ha encontrado (404) unas miles de paginas de este tipo:

https://midominio/litros/5/?filter_aroma=amoniacal&filter_marca=vijusa

https://midominio/etiqueta/platos/?filter_medida=17-cm&orderby=menu_order

https://midominio/litros/5/?filter_aroma=amoniacal&orderby=price-desc

Y así un largo etcétera. Uso Yoast, pero desde ahí no veo ninguna opción para arreglar esto.

En el robots txt he creado esta regla pero no veo que funcione:

#Bloqueo de busquedas

User-agent: *

Disallow: /*?

Disallow: /search

Disallow: /?orderby

Disallow: /?filter

¿Por favor me pueden ayudar? ¿Cómo decirle a google que pase de estas urls?

Gracias.

Contenido solo visible a usuarios registrados

Hola

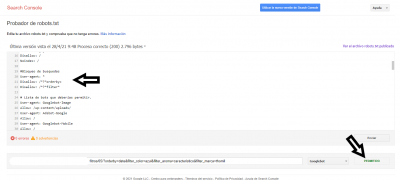

En el robots.txt prueba con:

Disallow: /*?*orderby=Disallow: /*?*filter*

La otra opción es hacerlo a través de Google Search Console, excluyendo urls con parámetros, revisa:

Salduos.

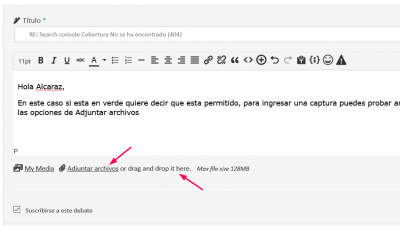

@jmarreros@jmarrerosMuchisimas gracias por responder tan rápido. He metido su código en robots txt. He probado con la herramienta de robot.txt para ver si bloqueaba el acceso y sale permitido y en verde. Eso es porque no los esta bloqueando, no? Tengo una captura de imagen pero no se como publicarla aqui

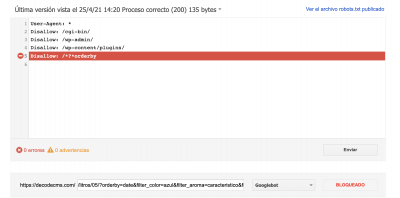

@jmarrerosMuchas gracias. Tenias razón, si que funciona, pero al parecer las siguientes líneas las he tenido que borrar porque con ellas si permitía entrar a los bots. Espero que eso no sea un problema, no?

# Previene problemas de recursos bloqueados en Google Webmaster Tools

User-Agent: Googlebot

Allow: /*.css$

Allow: /*.js$

Hola

Si, no hay problema.

Igual no te interesa que se indexe .css ni .js, además si borras el Allow es por defecto, es decir por defecto es Allow todas las urls

Saludos.

@jmarrerosMuchas gracias por todo. Sois la caña.